EU AI Act : Une révolution réglementaire pour les entreprises

Découvrez la nouvelle loi européenne sur l'IA : réglementation, impact significatif sur les entreprises et avenir prometteur de l'innovation technologique en Europe.

Découvrez la nouvelle loi européenne sur l'IA : réglementation, impact significatif sur les entreprises et avenir prometteur de l'innovation technologique en Europe.

En cette ère de transformation numérique rapide, l'Union Européenne (UE) adopte une position de leader mondial avec son approche innovante et réglementée de l'intelligence artificielle (IA). Cette stratégie, ancrée dans une vision à long terme, vise à harmoniser le développement technologique avec les principes fondamentaux des droits de l'homme, de la sécurité et de l'éthique. L'engagement de l'Europe pour une IA responsable soulève des questions essentielles sur l'équilibre entre l'innovation et la régulation, ainsi que sur les implications pour les acteurs du secteur, des startups aux géants technologiques, et sur l'impact sociétal global de ces technologies.

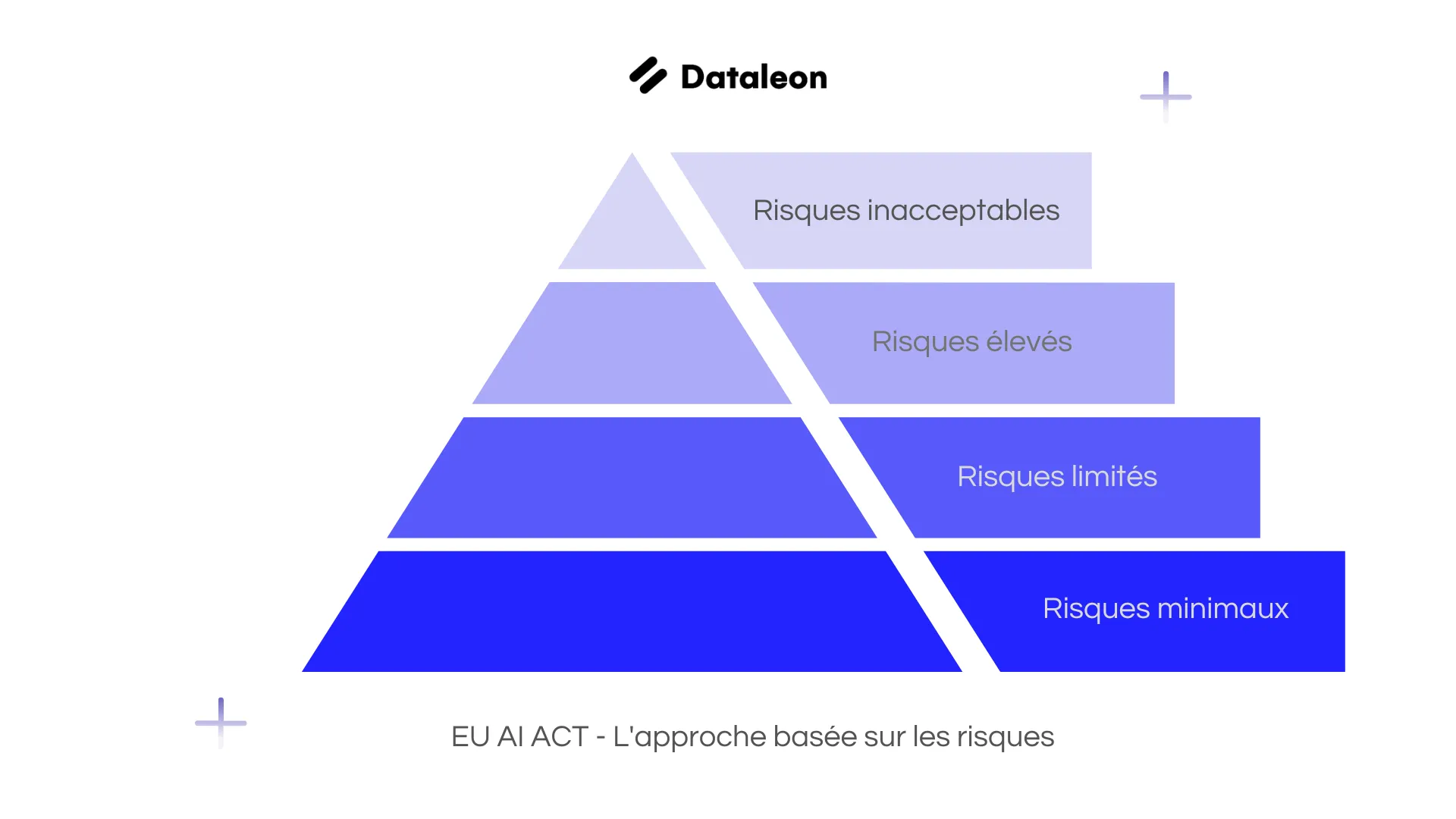

L'initiative réglementaire de l'UE en matière d'IA se distingue par sa démarche proactive et préventive, cherchant à encadrer les technologies émergentes avant qu'elles ne posent des défis insurmontables. Inspirée par le succès du Règlement Général sur la Protection des Données (RGPD), cette stratégie met en avant la nécessité d'une régulation qui soutient l'innovation tout en protégeant les citoyens contre les risques d'abus et de dérives potentielles. Le cadre réglementaire européen introduit un système de classification des risques associés à l'utilisation de l'IA, allant du niveau inacceptable au risque minimal, posant ainsi les bases d'une approche graduelle et flexible.

Au cœur de la stratégie européenne se trouve une classification basée sur le risque, distinguant les applications d'IA selon leur potentiel d'impact sur les individus et la collectivité. Cette approche granulaire, allant des risques inacceptables aux risques minimaux, permet une régulation nuancée qui encourage l'innovation responsable sans imposer un fardeau réglementaire indû aux applications présentant un faible risque pour la société.

L'adoption de ce cadre réglementaire présente à la fois des défis et des opportunités pour le secteur de l'IA. Les entreprises sont appelées à innover dans la manière dont elles conçoivent, développent et mettent en œuvre l'IA, avec un accent particulier sur l'éthique et la responsabilité sociale. Cela implique des investissements significatifs en matière de recherche et développement, ainsi que des ajustements dans les stratégies de mise sur le marché et les modèles opérationnels. Toutefois, cette transition vers une IA plus éthique et réglementée offre également aux entreprises l'opportunité de se différencier sur le marché, de renforcer la confiance des consommateurs et de s'aligner sur les valeurs sociétales de plus en plus centrées sur le respect de la vie privée et la durabilité.

Pour naviguer avec succès dans cette nouvelle réglementation, les entreprises doivent prendre des mesures proactives. Cela commence par une évaluation approfondie de l'utilisation de l'IA au sein de l'organisation, comprenant l'identification des cas d'usage spécifiques à l'IA et la classification de ces systèmes selon les catégories de risque définies par EU AI Act. Il s'agit notamment de déterminer si les applications relèvent des catégories de risque inacceptable, élevé, limité ou minimal. De plus, il est essentiel de créer un inventaire détaillé des applications d'IA, en précisant leur objectif, leur portée et les données traitées, tout en menant une analyse d'impact sur les individus et la société.

Au-delà de la compréhension des cas d'usage, l'élaboration de structures internes de gouvernance de l'IA est cruciale. Cela inclut la mise en place ou la révision de politiques d'éthique de l'IA alignées sur les principes de la loi Européenne sur l'IA, telles que le respect de l'autonomie humaine, la prévention des préjudices, l'équité et la transparence. La formation d'équipes interfonctionnelles, associant des compétences juridiques, de conformité, technologiques et commerciales, est recommandée pour superviser la gouvernance de l'IA. Par ailleurs, il est important d'assurer la formation et la sensibilisation des employés aux implications de cette loi et de promouvoir une culture de conformité et d'utilisation éthique de l'IA au sein de l'organisation.

Assurer la transparence et la responsabilité des données est également un pilier fondamental. Pour les systèmes d'IA, surtout ceux à haut risque, il est indispensable de documenter les sources de données, la qualité et les activités de traitement. Des mesures de transparence doivent être développées pour expliquer les processus décisionnels de l'IA aux parties prenantes internes et externes. Des audits de conformité réguliers et un plan de réponse aux incidents pour les systèmes à haut risque complètent cet arsenal, garantissant une préparation adéquate à la loi Européenne sur l'IA et positionnant les entreprises à l'avant-garde des pratiques éthiques de l'IA.

L'initiative de l'UE en matière de régulation de l'IA marque une étape importante dans la quête d'un équilibre entre le potentiel transformateur de l'IA et les impératifs éthiques et de sécurité. En adoptant une approche fondée sur les risques, l'Europe ne se contente pas de tracer les contours d'un avenir technologique responsable ; elle invite également les acteurs mondiaux à réfléchir au rôle de l'IA dans la construction d'une société plus juste, plus sûre et plus inclusive. Alors que nous avançons dans cette nouvelle ère de l'IA, l'expérience européenne offre des leçons précieuses sur l'importance d'une régulation réfléchie et proactive, soulignant que le progrès technologique doit aller de pair avec le respect de la dignité humaine et des droits fondamentaux.

Contactez nos experts pour des solutions innovantes et personnalisées

Tester la plateforme gratuitementNous contacter.svg)

15 jours d'essai

.svg)

Pas de carte de crédit

.svg)

Annulez à tout moment